Rückblick auf das AI & Cloud Innovation Meetup Karlsruhe

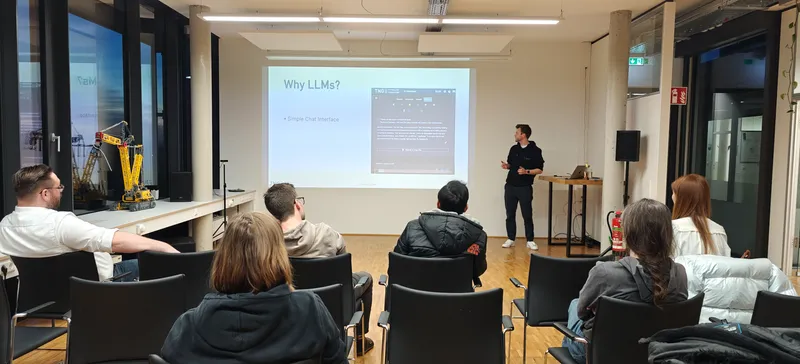

Letzte Woche haben wir in unserem Büro in Karlsruhe das AI & Cloud Innovation Meetup veranstaltet. Diesmal ging es darum, wie Large Language Models vom lokalen bis hin zum unternehmensweiten Einsatz skaliert werden können. In seinem Vortrag erläuterte unser Kollege Jonas Mayer, welche Hardware nötig ist, um verschiedene LLMs selbst zu betreiben. Dabei teilte er auch die Erfahrungen unseres internen KI-Teams, das ein GPU-Cluster aufgebaut hat, auf dem unsere selbstgehosteten LLMs für die insgesamt über 900 TNG-Kolleginnen und Kollegen zugänglich sind.

Viele Dank an alle Teilnehmerinnen und Teilnehmer. Wenn auch Sie LLMs selbst hosten möchten und bei der Einrichtung der Infrastruktur Hilfe benötigen, wenden Sie sich jederzeit an uns. Wir unterstützen Sie gerne.